-

spark executor core, memory 설정빅데이터/Spark 2020. 11. 30. 22:12

spark property 설정은 SparkConf, spark-shell, spark-submit, spark-defaults.conf 에서 할 수 있는데

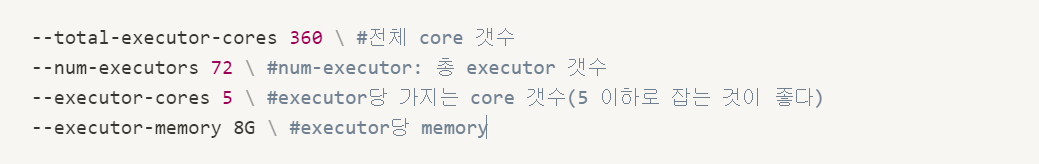

spark-submit 상에서 core와 memory를 효율적으로(최대한으로) 쓰고 싶어서 다음과 같이 설정해보았다.

전체 node 수는 9개, 각 node당 core는 40개, 각 node당 memory는 92GB

전체 core 갯수 ≥ 총 executor 갯수 * executor당 core 갯수

executor가 여러 노드에 걸쳐서 띄워지지 않으므로 executor memory를 설정할 때, 각 node의 memory도 고려해야 한다.

한 executor당 5 core를 잡았으므로 1 node당 8개의 executor가 띄워진다.(40/5 = 8)

1 node당 Memory는 92GB인데 OS 같은 시스템을 위해 1~2GB는 남겨두어야 하므로 90GB라고 생각했다.

90GB를 8로 나누면 11GB정도 되므로 11GB로 설정했다.

→ 1 Node당 11GB인 executor 8개 = 88GB, 9 Node이므로 전체 810GB 중 792GB정도 사용하게 된다.

'빅데이터 > Spark' 카테고리의 다른 글

spark error no space left on device 에러 해결 (0) 2020.12.01 Zeppelin Setting (0) 2020.11.30